Eventos

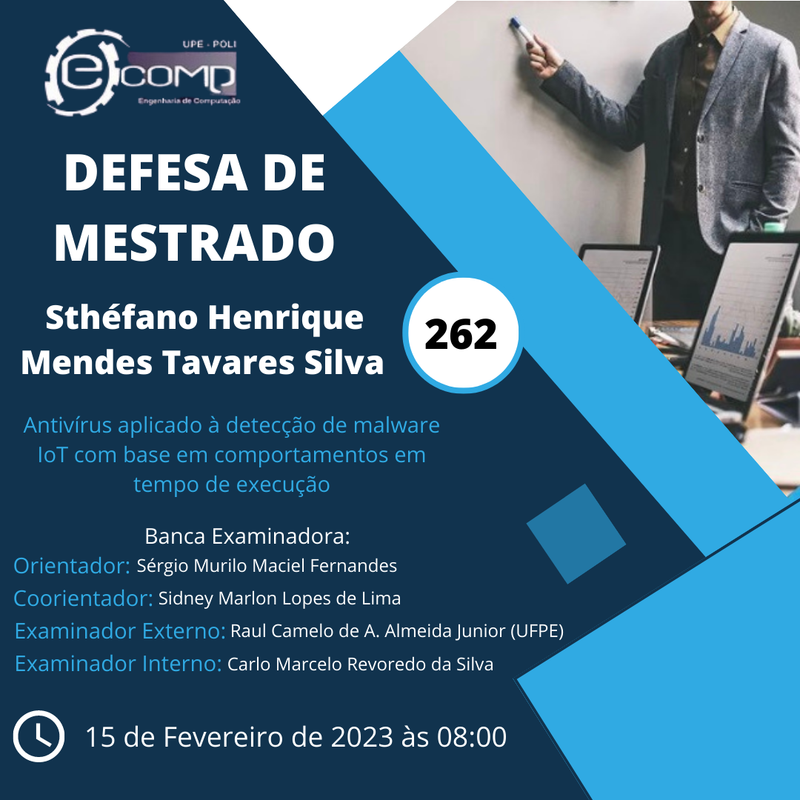

Divulgação - Defesa Nº 262

Aluno: Sthéfano Henrique Mendes Tavares Silva

Título: “Antivírus aplicado à detecção de malware IoT com base em comportamentos em tempo de execução”

Orientador: Sérgio Murilo Maciel Fernandes - (PPGEC)

Coorientador: Sidney Marlon Lopes de Lima - (PPGEC)

Examinador Externo: Raul Camelo de Andrade Almeida Junior - (UFPE)

Examinador Interno: Carlo Marcelo Revoredo da Silva - (PPGEC)

Data-hora: 15 de Fevereiro de 2023, às 08:00h.

Local: REMOTO (https://meet.google.com/cib-iodk-hwb)

Resumo:

Atualmente, a Internet das Coisas (IoT) tem um alto impacto na vida das pessoas, atingindo bilhões de dispositivos conectados à Internet. Devido à sua popularidade, tem aumentado o número de ataques cibernéticos voltados para esta tecnologia nos últimos anos. O constante surgimento de ameaças, como a botnet, o uso de técnicas complexas de evasão e, muitas vezes, a disponibilidade de grandes recursos para seu desenvolvimento, faz do malware a maior ameaça atualmente da IoT. A detecção e a mitigação do malware são essenciais para a operação normal dos dispositivos inteligentes. Os mecanismos de defesa tradicionais estão se tornando cada vez mais ineficazes devido às técnicas usadas pelos invasores que aumentam a resiliência do malware. Nesse contexto, o desenvolvimento de métodos de detecção de malware mais ágeis, adaptáveis e eficazes foi identificado como um dos principais requisitos para proteger a infraestrutura contra essas ameaças e garantir a sua segurança. Portanto, o presente trabalho visa propor um Antivírus de Análise Dinâmica de Malware, baseado em Redes Neurais Artificiais Rasas, dotado de aprendizado estatístico e Inteligência Artificial (IA), especializado na detecção de malware para arquitetura ARM de 32 bits voltadas para IoT. Em vez de modelos baseados em assinaturas, modelos empíricos ou heurística, o antivírus dotado de inteligência permite a detecção de malware ELF ARM de forma preventiva e não reativa como o modus operandi do Clamav e outros antivírus tradicionais. No ambiente de estudo, o arquivo ELF suspeito é executado visando infectar intencionalmente o GNU/Linux auditado em um ambiente controlado. O resultado dessa auditoria é transformado em atributos de entrada para os classificadores baseados em redes neurais do tipo Máquinas Morfológicas de Aprendizado Extremo (Morphological Extreme Learning Machines, mELMs). O objetivo do trabalho é demonstrar que a ausência ou limitação na detecção de software malicioso por antivírus comercial pode ser provida por um antivírus inteligente.

Divulgação - Defesa Nº 261

Aluno: João Antonio da Silva Lima

Título: “A análise da evasão escolar utilizando os modelos de regressão, diagrama de Ishikawa e os modelos teóricos de evasão”

Orientadora: Roberta Andrade de Araújo Fagundes - (PPGEC)

Examinador Externo: Paulo Mello da Silva - (UFRPE)

Examinador Interno: Carlo Marcelo Revoredo da Silva - (PPGEC)

Data-hora: 21 de dezembro de 2022, às 14:30h.

Local: Presencial: Mini-Auditório, no bloco C, 2º andar – UPE/POLI

Resumo:

A evasão dos alunos das instituições de ensino são questões que merecem atenção, principalmente nos países em desenvolvimento que foi agravado, por toda mudança econômica, política e educacional. Para investigar este processo, este trabalho tem o objetivo de apresentar uma Revisão Sistemática da Literatura (RSL) identificando as técnicas de Machine Learning (ML), especialmente os modelos de previsão, para prever a evasão escolar de estudantes do ensino médio utilizando os dados do Inep do ano de 2020 das escolas brasileiras. Como resultados foi utilizado a métrica de erro médio absoluto (EMA) entre os principais modelos utilizados, sendo: a regressão linear (EMA - 7,321462), Árvore de Decisão (EMA - 7,0665218) e regressão robusta (EMA - 6,785051), foi comprovado estatisticamente com o teste t-student. Como também, identificar as variáveis de entradas dos modelos de previsão através dos fatores e causas da evasão através do diagrama de Ishikawa e dos modelos teóricos de evasão.

Divulgação - Defesa Nº 260

Aluno: Lucas Candeia Teixeira

Título: “Detecção de ataques homográficos em páginas phishing: uma solução baseada em Redes Neurais Siamesas”

Orientador: Bruno José Torres Fernandes - (PPGEC)

Coorientador: Carlos Marcelo Revoredo da Silva - (PPGEC)

Examinador Externo: Péricles Barbosa Cunha de Miranda - (UFRPE)

Examinador Interno: Cleyton Mário de Oliveira Rodrigues - (PPGEC)

Data-hora: 23 de novembro de 2022, às 16:00h.

Local: Formato Remoto (https://meet.google.com/ofm-mvmk-vgs?hs=224)

Resumo:

O constante crescimento no volume de crimes cibernéticos bem sucedidos expõe não só uma fragilidade dos mecanismos de proteção, como também uma substancial suscetibilidade do usuário em tornar-se vítima das ações maliciosas. Um dos mais populares mecanismos para aplicação de tais violações são as páginas phishing, que possuem alto poder de persuasão e grande capacidade de adaptação, o que permite que o ataque contorne os bloqueios empregados pelos mecanismos anti-phishing. Com essas características, phishing tornou-se um dos modelos de ataque cibernético mais popular e eficaz em todo o mundo, fazendo inúmeras vítimas e causando incalculáveis prejuízos aos mais diversos setores. Muito da efetividade de ataques phishing está em sua capacidade de iludir o usuário para convencê-lo de que está acessando um serviço genuíno. Para tal função, muitas das investidas exploram a aplicação de termos homográficos para conferir fidedignidade ao ataque. Estima-se que cerca de 70% dos golpes exploram essa característica, no entanto, os mais populares mecanismos de proteção não possuem a capacidade de investigar a presença dos termos manipulados. Além disso, existe uma grande dificuldade na elaboração de bases de dados direcionadas a termos homográficos, dificultando a construção de arquiteturas inteligentes para detecção automatizada dos ataques. Neste cenário, o estudo propõe uma abordagem autônoma, baseada em uma rede neural siamesa recorrente do tipo LSTM, capaz de identificar a presença de termos homográficos em partes da URL e conteúdo das páginas phishing. De início, foi conduzida uma busca por bases de dados compostas por páginas maliciosas que contém ataques homográficos em sua composição. Ao fim dessa etapa, não foram identificadas bases de dados com tais características. Como solução para a problemática, foi construído um gerador de termos homográficos, capaz de construir diversas variações de uma marca-alvo, permitindo a aplicação das etapas seguintes. De posse dos dados, foi possível a execução de um ciclo de experimentos, onde foi avaliada a aplicabilidade do modelo baseado em aprendizado por representação para identificação de termos homográficos. Como resultado, o modelo proposto demonstrou possuir uma alta eficiência na detecção dos termos maliciosos, alcançando uma taxa de assertividade média de mais de 99,30%. Com isso, também pode-se comprovar a eficiência no modelo de geração de variações maliciosas, que ao receber trinta termos (marca-alvo) como entrada retornou mais de 33.000 variações homográficas. Conclui-se que a proposta possui uma significativa taxa de acerto, permitindo a identificação de termos homográficos com agilidade e confiabilidade, contornando diversos obstáculos para identificação dos mesmos.